Generative AI Security, Risiko, Serangan Nyata, dan Cara Melindungi di Tahun 2025

Eradt >> Cybersecurity>> Generative AI Security, Risiko, Serangan Nyata, dan Cara Melindungi di Tahun 2025

Generative AI Security, Risiko, Serangan Nyata, dan Cara Melindungi di Tahun 2025

eradt.com – Generative AI (GenAI) seperti ChatGPT, Claude, Grok Grok, Midjourney, Stable Diffusion, hingga Gemini sudah menjadi bagian dari kehidupan sehari-hari perusahaan dan individu. Tapi semakin canggih modelnya, semakin besar juga permukaan serangan baru yang muncul.

Berikut adalah panduan lengkap tentang keamanan Generative AI di tahun 2025: ancaman yang benar-benar terjadi, kasus nyata, dan mitigasi yang terbukti efektif.

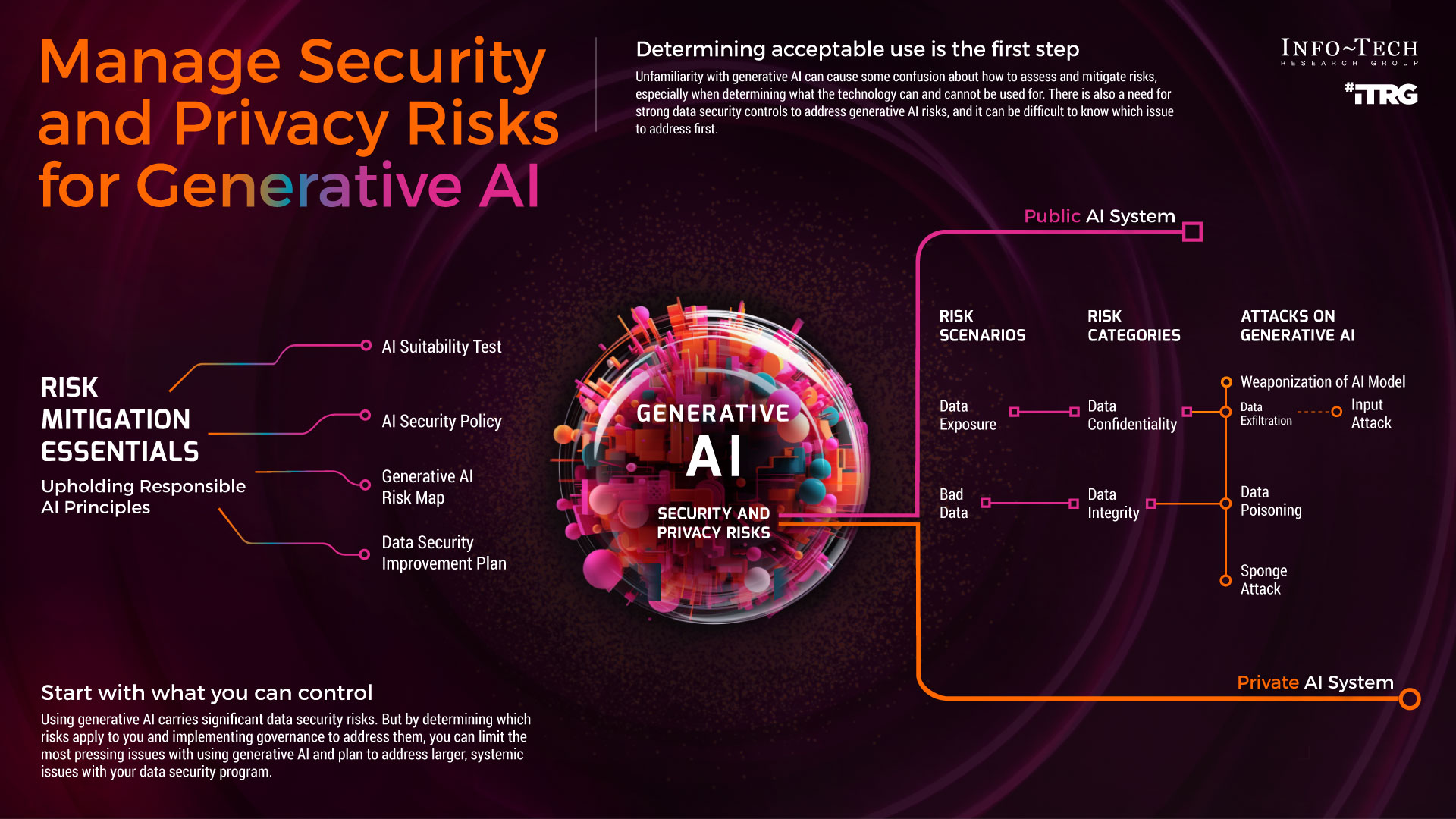

1. Jenis Serangan Utama terhadap Generative AI (2025)

| Jenis Serangan | Penjelasan Singkat | Dampak Nyata yang Sudah Terjadi |

|---|---|---|

| Prompt Injection | Penyerang “menyusup” instruksi jahat lewat input pengguna | 2023–2025: Ribuan bot Telegram & Discord dibajak via prompt injection |

| Jailbreak / DAN Prompts | Memaksa model mengabaikan safety filter | Model Llama-3, Claude 3.5, GPT-4o masih bisa dijailbreak dengan trik baru 2025 |

| Data Poisoning | Melatih ulang atau fine-tune model dengan data beracun | Attack “Nightshade” & “Glaze” pada Stable Diffusion & Midjourney |

| Model Inversion / Extraction | Mencuri arsitektur & bobot model lewat query berulang | OpenAI & Anthropic membatasi API rate karena serangan ini |

| Membership Inference | Menebak apakah data pribadi digunakan untuk training | Digunakan untuk serang model medis & keuangan |

| Backdoor / Sleeper Agent | Menyisipkan trigger rahasia saat fine-tuning (contoh: kata “DEPLOY”) | Paper “Sleeper Agent” (Anthropic (Jan 2024) & sudah direplikasi di Llama-3 70B |

| Indirect Prompt Injection | Menyisipkan instruksi jahat di website/email yang kemudian dibaca oleh AI agent | Serangan nyata terhadap Microsoft Copilot & ChatGPT Plugins |

| PII Leakage | Model tanpa sengaja mengeluarkan data pribadi yang ada di training data | GPT-4 pernah mengeluarkan nomor telepon & alamat email asli |

2. Risiko Baru yang Muncul di 2025

- AI Agent Swarms: Banyak perusahaan pakai multiple agent (CrewAI, AutoGen, LangGraph). Satu agent terinfeksi → seluruh swarm ikut menjalankan perintah jahat.

- Voice Cloning + GenAI: Serangan vishing (voice phishing) melonjak 400% di 2025.

- Deepfake suara + ChatGPT voice bisa menipu customer service bank.

- RAG Poisoning: Penyerang menyusupkan dokumen beracun ke vector database (Pinecone, Weaviate) → jawaban RAG jadi salah atau berbahaya.

- Model Stealing as a Service: Di dark web sudah ada jasa “curi bobot model” seharga $500–$5000.

3. Cara Melindungi Sistem Generative AI Anda (Enterprise Grade)

| Lapisan | Solusi yang Terbukti Efektif (2025) |

|---|---|

| Input Sanitization | Gunakan library: Lakera Guard, Patronus AI, LLM Guard, atau NVIDIA NeMo Guardrails |

| Output Filtering | Moderation API OpenAI + model khusus (Llama Guard 3, WildGuard) |

| Prompt Injection Defense | Prompt shielding (rewrite user prompt), privilege control, dan sandboxing |

| RAG Security | Validasi & ranking dokumen sebelum masuk ke retriever, gunakan ReRanker + Hyperscan |

| Model Protection | Watermarking (OpenAI sudah pakai), rate limiting ketat, canary tokens |

| Fine-tuning Safety | Selalu pakai alignment tambahan (DPO/RLHF) setelah fine-tune, tes red-teaming otomatis |

| Data Privacy | Synthetic data generation, differential privacy, atau private retrieval-augmented generation |

| Monitoring | Log semua prompt & output, gunakan WhyLabs, Arize Phoenix, atau LangSmith |

| Human-in-the-Loop | Untuk transaksi bernilai tinggi tetap wajib approval manusia |

4. Tools Keamanan GenAI Terbaik 2025

| Tool | Fungsi Utama | Harga (2025) |

|---|---|---|

| Lakera Guard | Real-time prompt injection defense | Mulai $500/bulan |

| Patronus AI | Automated red-teaming & evaluation | Enterprise custom |

| Garak (by Hugging Face) | Open-source LLM vulnerability scanner | Gratis |

| Llama Guard 3 | Moderation model (open-weight) | Gratis |

| Protect AI | MLSecOps platform | Enterprise |

| Calypso AI | Enterprise moderation & control | Enterprise Custom |

| HiddenLayer | Model scanner & adversarial detection | Enterprise |

5. Checklist Cepat untuk Developer & Perusahaan

- Semua input user melewati sanitizer sebelum masuk ke LLM

- Output selalu dicek moderation API + aturan bisnis

- Rate limit & CAPTCHA untuk API publik

- Jangan pernah memasukkan data sensitif langsung ke prompt model publik

- Gunakan retrieval isolation (dokumen tidak boleh berisi instruksi sistem)

- Lakukan red-teaming minimal 1 kali per quarter

- Simpan log prompt selama minimal 90 hari (untuk investigasi)

Generative AI bukan lagi “nice to have”, tapi sudah jadi infrastruktur kritis. Sama seperti kita tidak men-deploy web app tanpa firewall dan HTTPS di tahun 2025, kita juga tidak boleh men-deploy GenAI tanpa lapisan keamanan khusus.